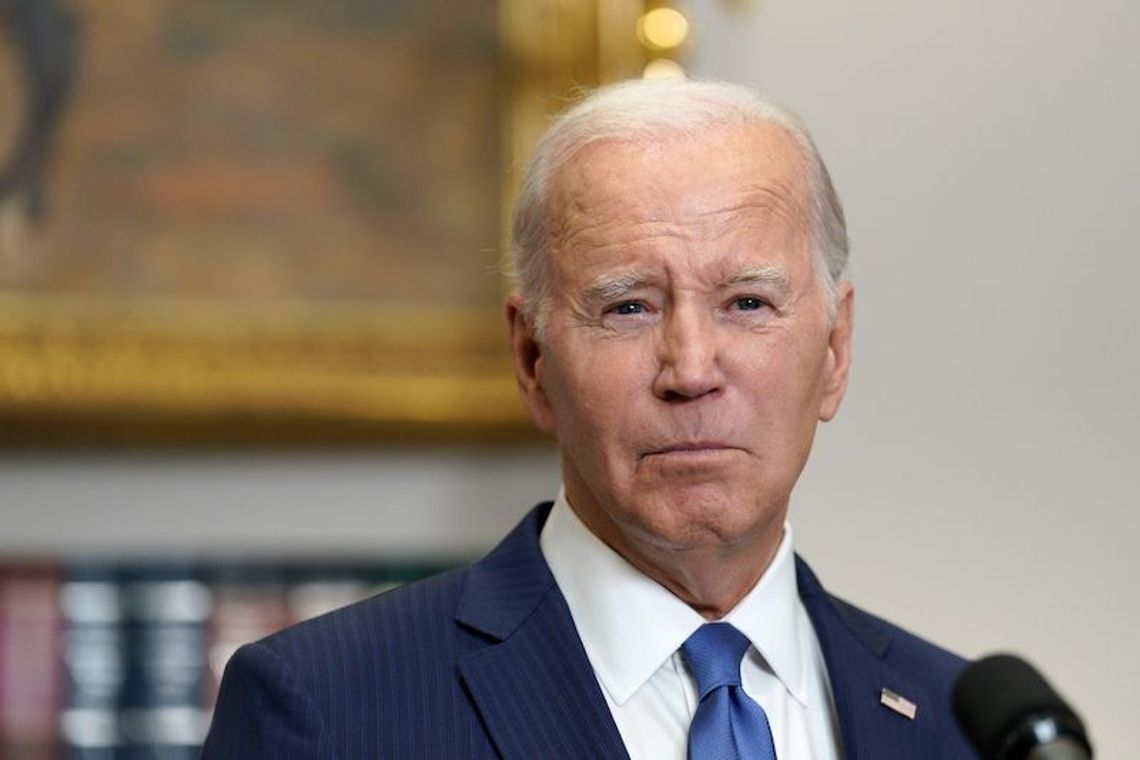

Prezydent Joe Biden ogłosił w piątek, że siedem największych amerykańskich firm pracujących nad sztuczną inteligencją (AI) zobowiązało się dobrowolnie przestrzegać szeregu zasad mających zapewnić bezpieczeństwo ich produktów. Firmy, w tym m.in. Microsoft, Google i Meta, obiecały też, że dopuszczą zewnętrznych ekspertów do testowania programów przed ich wypuszczeniem.

Podczas przemówienia w Białym Domu w obecności prezesów i przedstawicieli koncernów, Biden powiedział, że w ramach zaproponowanej przez jego inicjatywy, firmy zobowiązały się do działań w czterech obszarach. Chodzi m.in. o testowanie możliwości systemów AI przez wewnętrznych i zewnętrznych ekspertów wraz z publikacją wyników tych testów. Ponadto firmy mają objąć priortytetem bezpieczeństwa swoje systemy przed cyberatakami, jasno oznaczać treści wygenerowane przez AI, a także inwestować w rozwiązania oparte na sztucznej inteligencji dotyczące największych problemów społeczeństwa, od leczenia raka, przez zmiany klimatu po tworzenie miejsc pracy.

"Te zobowiązania są prawdziwe i są konkretne" - zaznaczył prezydent. Zaznaczył jednocześnie, że obok dobrowolnych zobowiązań firm potrzebne są nowe prawa, regulacje i nadzór. Biden zapowiedział, że zamierza wkrótce "podjąć działania wykonawcze, by pomóc Ameryce przewodzić w drodze do odpowiedzialnej innowacji".

W inicjatywie oraz spotkaniu z prezydentem w Białym Domu - już takim drugim w ciągu ostatnich miesięcy - udział wzięli prezesi siedmiu największych koncernów rozwijających technologię AI: Microsoft, Google, Meta, OpenAI, Anthropic, Inflection AI, Amazon.

Z Waszyngtonu Oskar Górzyński (PAP)